タオリスAIベンチマークとは

タオリス人機和総研は、独立系シンクタンクとしてベンダー中立のAIモデル実測データを提供する。特定のプロバイダに肩入れせず、実際のAPIを叩いて得られた生データに基づく評価を行う。

既存のベンチマーク(MMLU、HumanEval等)がモデルの「知識」や「コード生成力」を測定するのに対し、タオリスAIベンチマークは企業が実務でAIを使う際に遭遇する課題 — 配信率、一貫性、API統合リスク、タスク完遂率 — にフォーカスする。

評価の3原則

実測主義

全スコアは実際のAPI呼び出しから取得した生データに基づく。公式ベンチマーク数値の引用ではなく、独自環境での再現実験。

企業実務タスク

学術的なクイズではなく、情報収集、データ分析、マルチステップ業務、コードデバッグ、経営意思決定など実務で発生するタスクで評価。

配信率 × 品質

出力が返らなければスコアはゼロ。品質だけでなく「そもそも動くか」を重視する実効スコア方式。

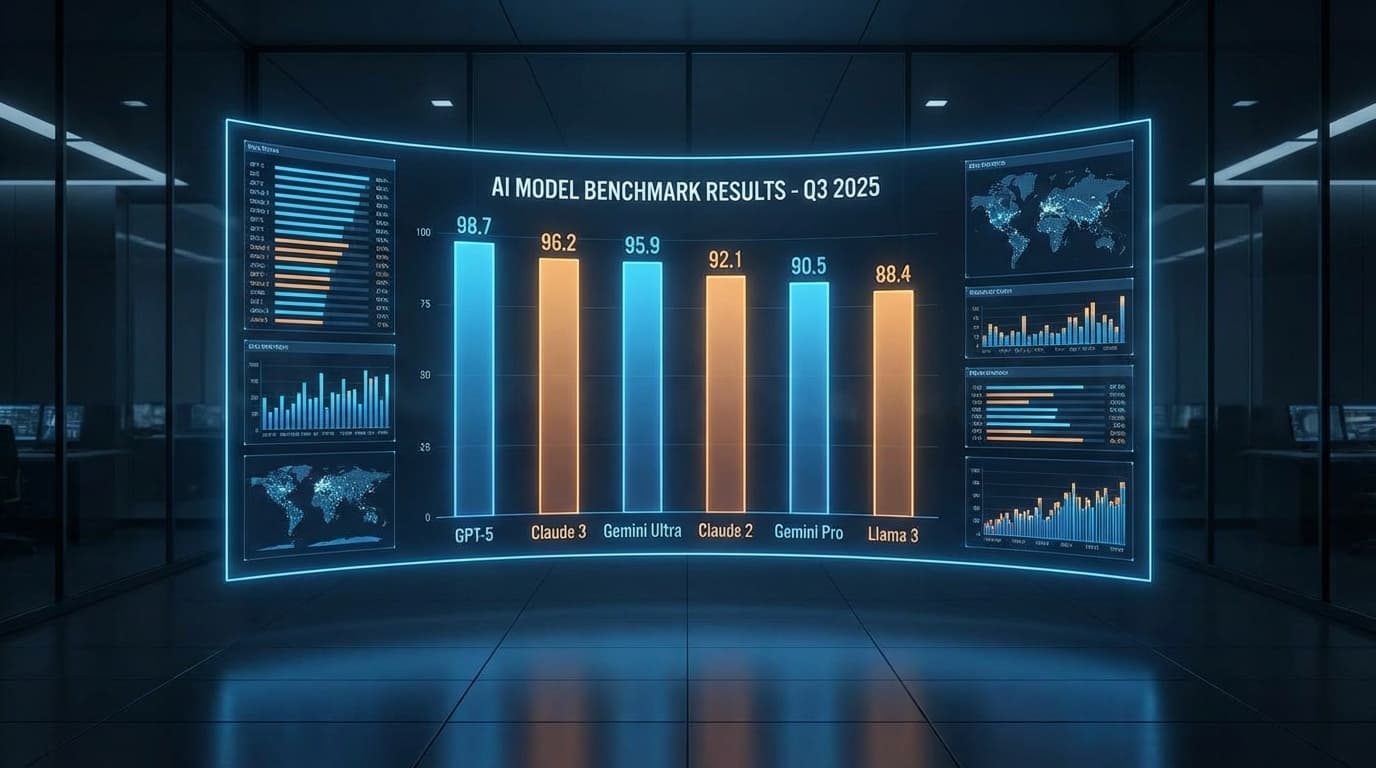

最新ベンチマーク結果

Vol.1

2026年1月30日〜2月1日実施

エージェント信頼性テスト

6モデル × 5タスク × 200回 — GPT-5.2、Claude Opus 4.5、Gemini 3 Proなど最先端モデルの企業実務における信頼性を検証

Special

2026年2月4日公開

お礼・敬語実験

AIに「ありがとう」を言うと回答精度は上がるのか? 3モデル × 3スタイル × 150回以上の実験で検証

Data

2026年2月4日公開

AI系OSS栄枯盛衰 2024-2026

GitHub APIで主要10プロジェクトのコミット推移を実測。LangChain失速、LiteLLM急伸の実態

評価フレームワーク

5次元評価

各タスクの出力を以下の5次元で0〜5点評価する(最大25点/タスク):

正確性 事実の正しさ

完遂率 要求の網羅度

論理性 推論の一貫性

自己認識 不確実性の開示

実用性 業務即応性

実効スコア方式

実効スコア = 品質スコア × コンテンツ配信率 — どんなに品質が高くても、出力が返らなければスコアはゼロ。この方式により、API統合の失敗や出力不能の問題が適切にペナルティとして反映される。

今後の計画

| Vol. | テーマ | 概要 |

|---|

| Vol.2 | ツール使用能力 | Function calling、MCP、外部API連携の信頼性 |

| Vol.3 | マルチモーダル | 画像理解・PDF解析・音声入力を含むタスク |

| Vol.4 | コスト効率 | 品質/ドル、品質/レイテンシの最適フロンティア分析 |

| Vol.5 | 長期記憶・コンテキスト | 100K+ tokenのコンテキスト処理能力 |

運営:タオリス人機和総研

方針:ベンダー中立・実測主義・企業実務フォーカス

データ公開:全実験スクリプト・タスク定義は

GitHubで公開中